Платформа автоматической обработки геофизической информации на основе ИИ

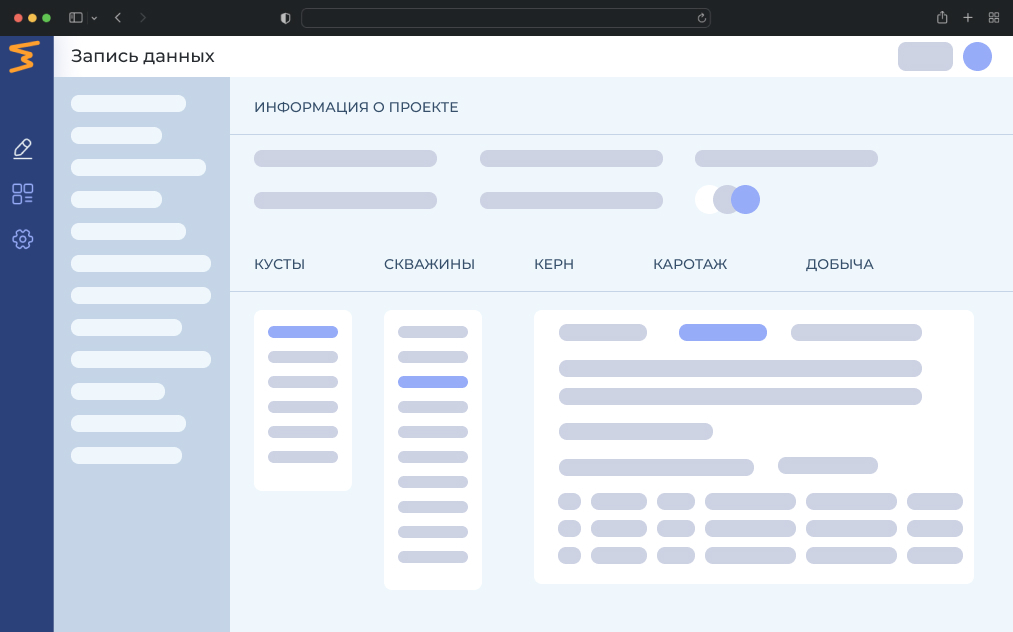

IT-продукт inLog для сбора, хранения, оценки качества и продвинутой аналитики геофизической информации месторождений.

SaaS-платформа для оптимизации управления и анализа данными в блоке разведки и добычи углеводородов.

Решение позволит сократить на 80% время и затраты на операции с данными, кратно ускорить интерпретацию данных, а также получать цифровой двойник месторождения в 1 клик. Функциональность платформы INLOG повышает качество технологических и стратегических принятий решений.

Решение позволит сократить на 80% время и затраты на операции с данными, кратно ускорить интерпретацию данных, а также получать цифровой двойник месторождения в 1 клик. Функциональность платформы INLOG повышает качество технологических и стратегических принятий решений.

Облачное решение в контуре компании

Сбор, хранение, оценка качества и унификация данных

Современные архитектурные IT-решения в продукте повышают эффективность бизнес-процессов, связанных с управлением данными из блока разведки и добычи.

Интеграция с ИИ, выход

на автоинтерпретаторы

на автоинтерпретаторы

Применение передовых методов на основе машинного обучения в комбинации с классическими подходами и знанием о физике пласта кратно ускорят, повысят качество анализа информации и сократят операционные затраты.

Цифровой двойник

месторождения

месторождения

Решает проблему отсутствия IT-инфраструктуры и неструктурированных данных разведки и добычи.

Преимущества сервиса

ИИ-движокАвтоматизация процессов сбора данных, анализа и обработки информации.

ИИ-движокАвтоматизация процессов сбора данных, анализа и обработки информации. Унификатор данныхПреобразовывает и стандартизирует данные в различные форматы, чтобы сделать их более удобными для анализа и использования.

Унификатор данныхПреобразовывает и стандартизирует данные в различные форматы, чтобы сделать их более удобными для анализа и использования. Облачный сервисПредоставляет возможность хранить и обмениваться данными в облаке. Обеспечивает безопасность данных.

Облачный сервисПредоставляет возможность хранить и обмениваться данными в облаке. Обеспечивает безопасность данных. Планировщик задачТаск-менеджер с возможностью привязывать задачи к проектам и назначать разные роли исполнителям.

Планировщик задачТаск-менеджер с возможностью привязывать задачи к проектам и назначать разные роли исполнителям. Оценка качества данныхПовышает эффективность организации процессов лаборатории и управления данными.

Оценка качества данныхПовышает эффективность организации процессов лаборатории и управления данными. Совместная работаМногопользовательский удаленный доступ к общей базе. Обеспечивает бесперебойную совместную работу над проектами.

Совместная работаМногопользовательский удаленный доступ к общей базе. Обеспечивает бесперебойную совместную работу над проектами.

Удобный и понятный интерфейс

Проект поддержан Фондом Содействия Инновациям в рамках федерального проекта «Платформа Университетского Технологического Предпренимательства»

Контакты

По вопросам сотрудничества:

Руководитель проекта: Юрий Мешалкин

Телефон: +7 (913) 016-14-10

Email: yury.meshalkin@data-factory.ru

© ООО «ДАТА ФАКТОРИ»

ИНН 3804117702

ОГРН 1223800021940

Телефон: +7 (913) 016-14-10

Email: yury.meshalkin@data-factory.ru

© ООО «ДАТА ФАКТОРИ»

ИНН 3804117702

ОГРН 1223800021940